作为一名专注于AI与自动化的内容创作者,我一直在探索能够提升工作效率的各类工具。在数据采集和自动化领域,我发现Apify是一个不可多得的利器。它不仅能与我经常分享的Make.com完美配合,还能为AI应用提供强大的数据支持。今天我将详细为大家介绍这个强大的平台,分享我的使用心得和实战经验。具体实践案例可以观看如下视频学习使用方法。

什么是Apify?

Apify是一个成立于2015年的云端网络爬虫和自动化平台。作为一个专注于Make.com自动化的博主,我发现Apify能够完美补充Make.com在数据采集方面的不足。它提供了一个完整的基础设施,让用户可以轻松地从网络上获取数据,并将这些数据用于各种自动化场景。

这个平台最吸引我的是它的易用性和强大功能的完美结合。即使你没有编程基础,也可以通过其直观的界面轻松开始数据采集工作。对于开发者来说,它还提供了强大的API和SDK支持,让你能够构建更复杂的自动化方案。

在我的实际使用中,Apify在以下几个方面表现出色:

- 数据采集的准确性和稳定性极高

- 提供原生Make模块,无需API即可快速开启采集任务

- 性价比很高,免费版本就能满足基础需求

- 支持各类主流平台数据采集:

• 电商平台:亚马逊、eBay、Shopify等

• 社交媒体:Facebook、Twitter、Instagram等

• 搜索引擎:Google、Bing等

• 新闻媒体:各大新闻网站和RSS源

• 招聘网站:LinkedIn、Indeed等

• 评论平台:Yelp、TripAdvisor等

核心优势

即用即取的数据采集工具

- 提供2000+预建的数据采集Actor(爬虫)

- 支持主流社交媒体、电商平台的数据获取

- 无需编程知识即可使用

- 数据输出格式丰富(JSON、CSV、Excel等)

强大的自动化能力

- 支持定时任务调度

- 提供API接口便于集成

- 可与Make.com等自动化平台无缝对接

- 支持webhook触发器

企业级的稳定性

- 内置代理管理系统

- 自动处理反爬虫机制

- 高并发处理能力

- 完善的监控和告警机制

AI友好的数据处理

- 支持结构化数据输出

- 提供向量数据库集成

- 适配主流LLM训练需求

- 支持RAG应用场景

主要应用场景

社交媒体数据采集

作为一名自媒体博主,我深知高质量内容创作需要持续的灵感输入和行业洞察。通过将 Apify 与 Make.com 结合使用,我构建了一套完整的创作灵感采集系统。这套系统帮助我实现了从行业动态监控到竞品分析的全流程自动化,极大提升了内容创作效率。

在行业动态追踪方面,我使用 Apify 的 Twitter Scraper 持续监控自动化与AI行业热点。系统会自动采集他们发布的最新内容,通过 Make.com 的工作流对内容进行智能分类和关键信息提取。这些处理后的信息会自动存储到我的 Notion 数据库中,并根据预设的关键词触发即时通知。这让我能够第一时间掌握行业热点,快速进行自媒体内容的创作。

在创作素材管理方面,所有采集的内容都会经过智能分类并存入专门的素材库。通过 Make.com 的自动化流程,系统会定期对素材进行分析和整理,生成潜在的选题建议和内容大纲。这些建议会考虑当前热点话题、历史内容表现和受众兴趣等多个维度,帮助我做出更好的选题决策。

通过这套系统的运行,我的内容创作效率得到了显著提升。每天我能够自动获取超过100条高质量的行业动态,更重要的是,这套系统让我能够始终站在行业前沿,持续输出有价值的内容。

AI训练数据准备

在当前AI快速发展的背景下,高质量的训练数据变得越来越重要。Apify提供了专门的工具来支持AI数据采集需求。它不仅可以采集网页文本内容、图片和视频资源,还能获取用户评论反馈以及结构化的商品信息。这些数据可以广泛应用于LLM训练数据收集、AI助手知识库构建、情感分析数据集制作以及图像识别训练集准备等多个AI应用场景。通过Apify强大的数据采集能力,开发者可以更便捷地获取高质量的AI训练数据,从而提升AI模型的训练效果。

价格方案

Apify提供灵活的定价模式,充分考虑了不同用户的需求:

订阅计划

Apify为用户提供了免费版和专业版两种订阅计划。免费版每月提供价值$5的使用额度(约20个计算单位),支持10个并发任务,使用共享代理,数据保留7天,并提供社区支持。虽然免费版的额度有限,但对于个人用户来说已经相当实用。用户可以用它来完成每天抓取几个网页内容、监控特定产品价格变化等小型任务。通过合理规划任务执行时间,这些额度完全可以支持相当多的数据采集需求。

专业版则面向有更多需求的用户,每月收费$49,提供100个计算单位、25个并发任务额度,以及10GB的独享代理资源。此外还包括30天的数据保留期限、完整的API访问权限和专业的技术支持服务。这个版本特别适合需要稳定进行数据采集的个人创作者和小型团队使用。

选择建议

对于个人用户:

- 建议从免费版开始,熟悉平台的各项功能。免费版提供的额度其实已经能满足很多基础场景的需求。

- 当数据采集需求增加且稳定时,再考虑升级到专业版

- 对于临时性的大规模任务,可以选择按需付费方式

使用建议:

- 合理规划采集任务,避免额度浪费

- 根据实际需求选择合适的代理方案

- 及时导出重要数据,避免过期清理

Make中使用Apify教程

注册Apify账号

- 访问Apify官网(apify.com)注册新账号

- 选择免费版计划

- 完成邮箱验证

- 登录控制台

创建数据采集任务

- 进入Apify控制台

- 点击”Store”浏览预置Actor

- 选择需要的Actor(如Twitter Scraper)

- 配置采集参数(如关键词、数量等),然后复制该采集参数

- 点击”create task”创建任务

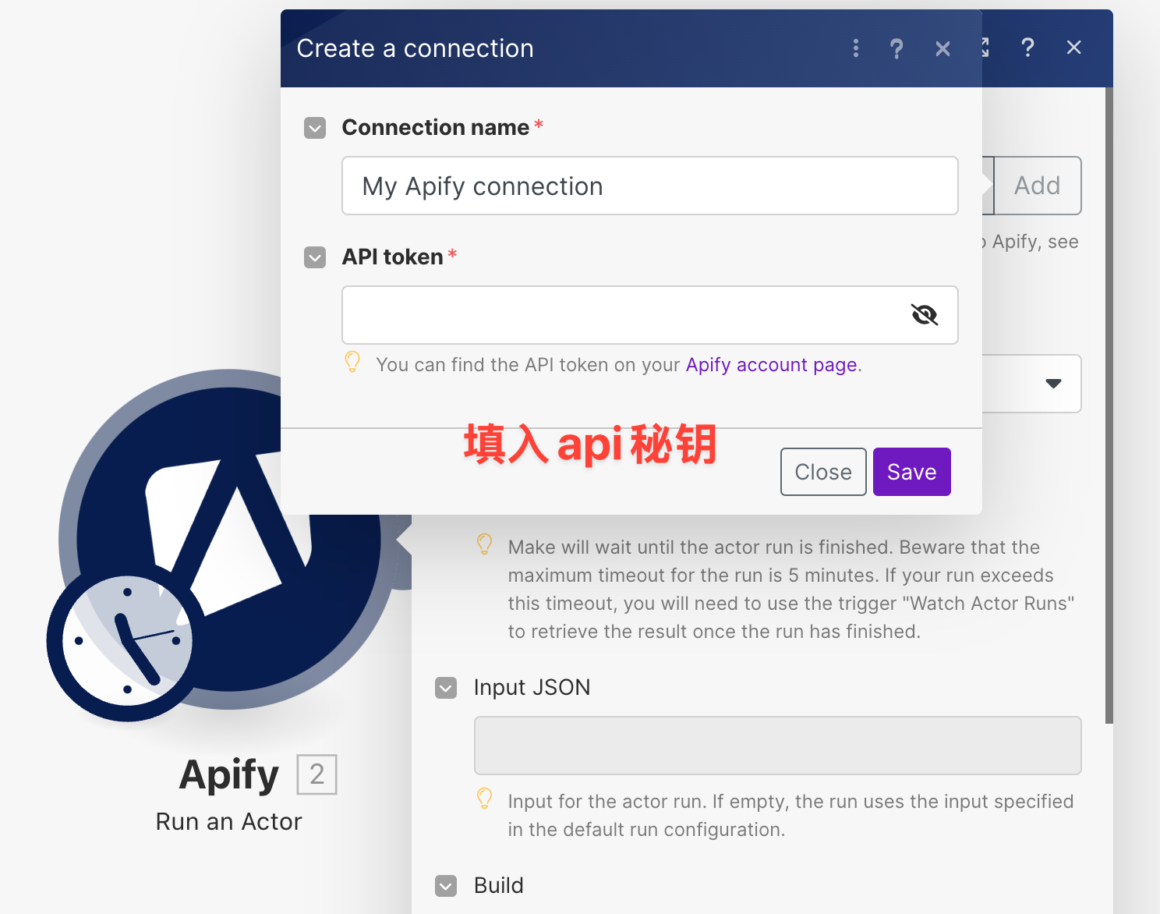

获取API密钥

- 进入Account Settings(账号设置)

- 找到Integration(集成)选项

- 生成新的API密钥并保存

配置Make连接

- 登录Make平台

- 创建新场景

- 添加Apify模块

- 创建新连接并填入API密钥

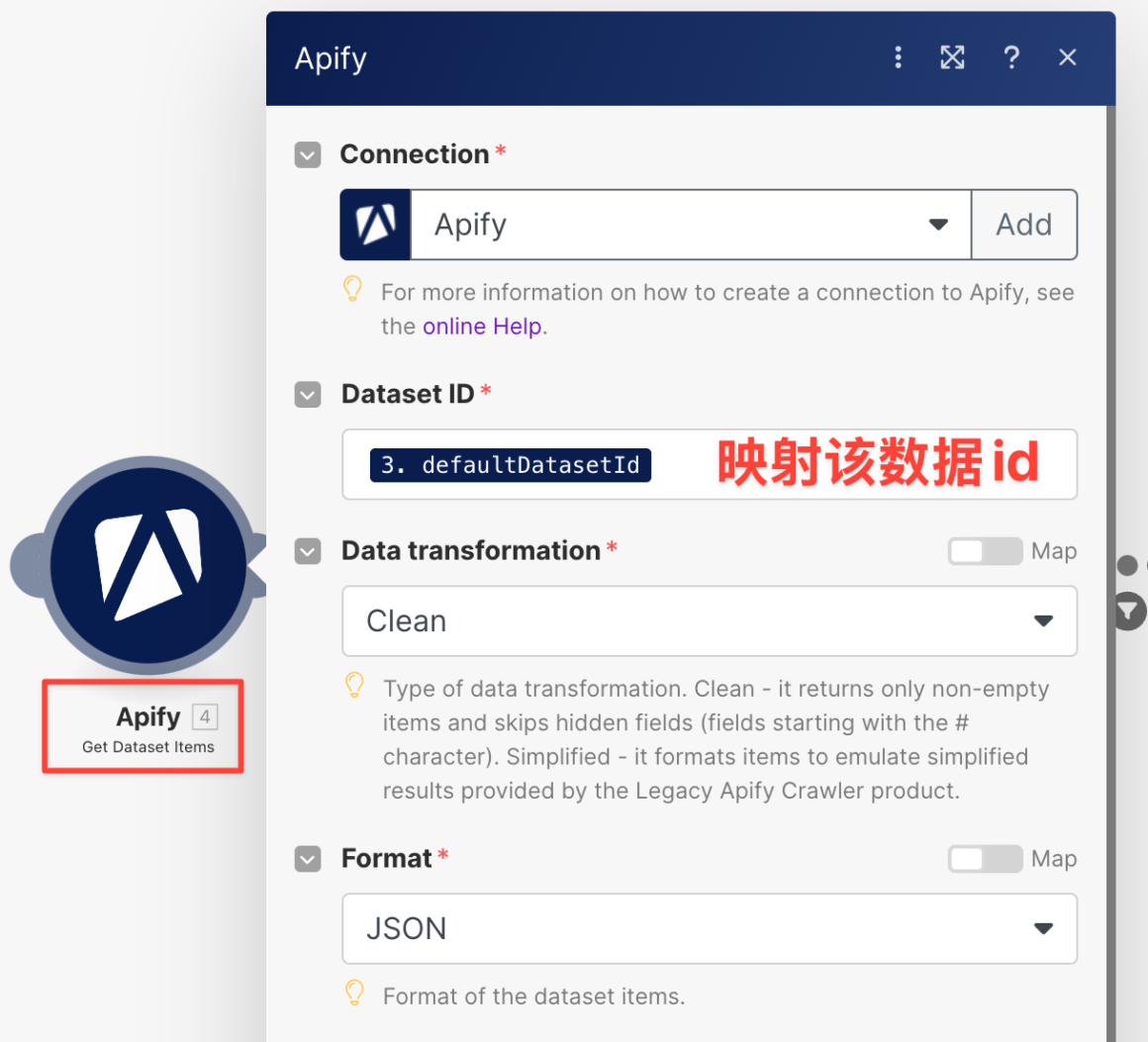

- 测试连接是否成功

Make中运行Actor

- 选择”Run Actor”操作

- 选择已创建的Actor

- 输入采集参数参数

- 添加数据处理模块

- 开始运行

获取采集数据

- 完成工作流

- 设置等待时间

- 添加数据过滤条件

- 获取采集数据

实战案例分享

作为一个专注于AI与自动化的博主,我经常使用Apify来支持我的内容创作和自动化工作流。通过实际案例的分享,我希望能帮助大家更好地理解Apify的应用价值。

在内容研究方面,我构建了一套完整的自动化工作流。首先使用谷歌搜索结果,然后通过Website Content Crawler深入抓取文章内容。这些原始数据会通过Make.com进行处理和分析,生成结构化的内容大纲。最后,我会利用AI助手基于这些材料生成文章初稿,大大提升了内容创作的效率。

在AI训练数据采集方面,我主要使用Website Content Crawler来获取专业领域的内容。这些内容经过清洗和结构化处理后,会被导入到向量数据库中。这些高质量的训练数据为我开发专业领域的AI助手提供了重要支持。

总结

作为一个专注于Make.com自动化的博主,我认为Apify是一个非常实用的补充工具。它的免费版每月提供5美元的额度,对于个人用户来说已经足够应付日常的数据采集需求。比如每天抓取几个网页内容、监控特定产品价格等小型任务都完全够用。通过合理规划任务执行时间,这些免费额度可以创造很高的价值。

对于想要尝试自动化的新手用户来说,我建议先从免费版开始。它不仅能让你零成本体验Apify的核心功能,还能与Make.com完美配合,实现不少实用的自动化场景。等到后期数据采集需求增加且稳定时,再考虑升级到专业版。

最后,我会在后续的文章中继续分享更多关于如何充分利用Apify免费额度,以及与Make.com结合使用的实战案例,敬请期待!